I governi dovrebbero considerare i processi elettorali come infrastrutture critiche da preservare con soluzioni tecnologiche ad hoc e adottando leggi per regolamentare l’uso dell’intelligenza artificiale generativa. L’analisi di Pierluigi Paganini, amministratore delegato di Cybhorus e membro dell’Ad-Hoc Working Group on Cyber Threat Landscapes dell’Enisa

Nel 2024 in molti Paesi del mondo si terranno elezioni il cui esito potrebbe avere un impatto geopolitico significativo sui delicati equilibri diplomatici. Le elezioni del Parlamento europeo in giugno, le presidenziali negli Stati Uniti in novembre, e poi le presidenziali in Francia in aprile e quelle in settembre in Germania. La strategia politica dell’Europa, i suoi rapporti con Cina e Russia, sono sicuramente influenzabili attraverso la manipolazione del voto degli stati sopra elencati.

Secondo l’ultimo rapporto sulle minacce dell’Agenzia europea per la sicurezza informatica (Enisa) c’è stato un aumento dell’utilizzo chatbot basati sull’intelligenza artificiale per attività fraudolente, dei deepfake e di tecnologie simili negli ultimi 12 mesi. Le elezioni dell’Unione europea del 2024 sono minacciate dai contenuti generati attraverso queste piattaforme. “La fiducia nel processo elettorale dell’Unione europea dipenderà in modo cruciale dalla nostra capacità di fare affidamento su infrastrutture di sicurezza informatica e sull’integrità e disponibilità delle informazioni”, ha affermato il direttore esecutivo dell’agenzia, Juhan Lepassaar.

Ampliando l’orizzonte di analisi è possibile verificare che anche in Cina, Giappone, Russia, Brasile e Regno Unito ci saranno elezioni nei prossimi mesi. È corretto quindi sostenere che le elezioni del 2024 saranno un momento cruciale per la politica mondiale e per questo motivo non immuni a operazioni volte a influenzarne l’esito. Le presidenziali statunitensi del 2016 e la Brexit hanno dimostrato come attraverso la manipolazione dell’informazione sia possibile influenzare la percezione di intere popolazioni su temi di interesse per la collettività. Diversi attori statuali tenteranno di interferire con le operazioni di voto, appoggiando i candidati la cui politica è in linea con gli interessi dei propri governi.

L’intelligenza artificiale è sicuramente una arma formidabile nelle mani di questi attori che potrebbero farne ricorso per influenzare il risultato delle elezioni. L’impiego dell’intelligenza artificiale generativa può consentire di condurre campagne di disinformazione su larga scala e con un’efficacia mai vista prima. Un attaccante potrebbe utilizzare l’intelligenza artificiale generativa per creare contenuti realistici, come immagini, video e audio, che possono influenzare l’opinione pubblica in diversi modi. Audio e video falsi creati ad hoc, e diffusi prima delle elezioni, potrebbero danneggiare un partito o un candidato. L’utilizzo di un sistema basato su intelligenza artificiale potrebbe consentire di creare questi contenuti in tempo reale basandosi su eventi reali e sul livello di coinvolgimento dei cittadini a discussioni pubbliche sulle principali piattaforme di social networking. Reti di chatbot potrebbero ingaggiare i cittadini in discussioni su temi politici, creando malcontento e sfiducia nei confronti dei governi presi di mira.

L’intelligenza artificiale può essere utilizzata non solo per creare contenuti, ma anche per selezionare obiettivi e definire strategie di diffusione che possano eludere i controlli implementati dalle aziende che gestiscono i social media e le piattaforme di instant messaging. L’intelligenza artificiale sarà impiegata dai candidati, così come da attori malevoli statuali, per l’analisi dei dati sui modelli di voto, la creazione di messaggi da inviare a residenti e l’analisi delle loro abitudini dei social media.

Alcuni esperti inoltre ipotizzano che l’intelligenza artificiale potrebbe essere utilizzata per attaccare rappresentati politici e interi partiti. Siamo consapevoli che l’intelligenza artificiale generativa può essere addestrata per creare campagne di spear-phishing difficili da individuare e che prendano di mira proprio i candidati diffondendo poi il contenuto delle loro caselle di posta con l’intento di manipolare l’opinione pubblica sulla loro condotta.

Le tecniche di manipolazione dell’opinione pubblica basate sull’intelligenza artificiale possono essere diverse e probabilmente siamo ancora impreparati per contrastarle. In molti casi, il contrasto è affidato alle aziende che gestiscono le piattaforme social e le cui strategie sono principalmente guidate dal profitto. Quest’aspetto è tutt’altro che trascurabile perché le azioni di contrasto ad abusi di sistemi basati sull’intelligenza artificiale prevedono investimenti ingenti da parte di queste aziende e l’adozione di pratiche di gestione del dato che sono regolamentate dai differenti quadri normativi dei Paesi in cui operano.

La necessità di vigilare sui contenuti online arriva in un periodo storico in cui molte delle più grandi aziende tecnologiche hanno tagliato il personale dedicato alla lotta alla disinformazione. “Le elezioni del 2024 saranno un disastro perché i social media non ci proteggono dall’IA utilizzata per generare falsi contenuti”, ha recentemente dichiarato Eric Schmidt, ex amministratore delegato di Google e co-fondatore di Schmidt Futures, alla CNBC.

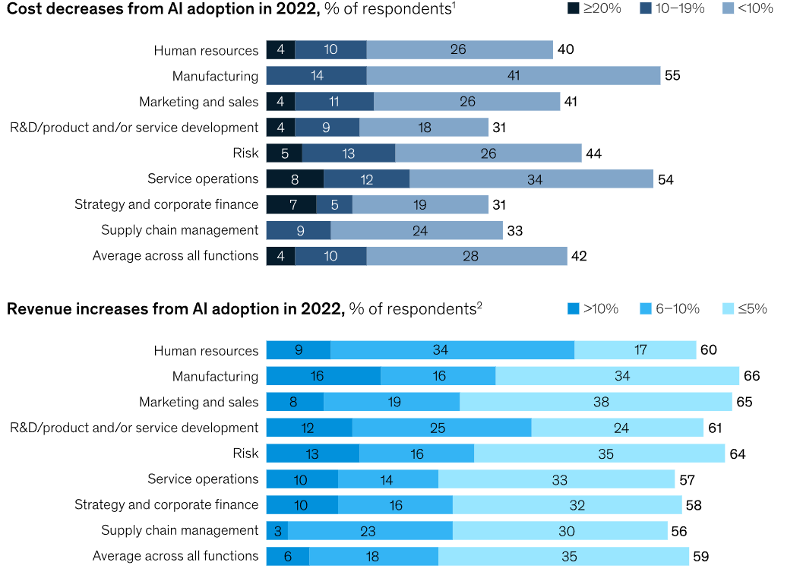

Comprese le minacce è quindi lecito chiedersi quali possano essere le sorgenti degli attacchi e per far ciò occorre comprendere quali sono gli Stati che investono maggiormente nella ricerca sull’intelligenza artificiale. Secondo un rapporto pubblicato da McKinsey & Company, i Paesi più avanzati negli investimenti in intelligenza artificiale sono Stati Uniti, Cina, Regno Unito, Germania e Giappone. Questi Paesi guidano l’innovazione nell’intelligenza artificiale in termini di ricerca e sviluppo e investimenti. Gli Stati Uniti sono riconosciuti come leader mondiale nell’intelligenza artificiale, all’America si riconosce un ecosistema di ricerca e sviluppo come pochi. La Cina sta investendo in maniera importante nell’intelligenza artificiale, con l’ambizioso obiettivo di diventare leader mondiale entro il 2030. Il Regno Unito e la Germania sono riconosciuti come driver nell’intelligenza artificiale. L’intelligenza artificiale sta avendo un impatto significativo su vari settori, come salute, finanza, e produzione. I Paesi che investiranno di più saranno inevitabilmente quelli più avanzati e nel medio e lungo periodo difficilmente daranno spazio a regolamentazioni internazionali che ne limitino lo sviluppo e l’egemonia tecnologica acquisita.

L’intelligenza artificiale trasformerà il mondo in cui viviamo e governare la sua evoluzione equivale ad acquisire un vantaggio difficilmente colmabile nei prossimi anni. Alcuni di questi Paesi, inoltre, potranno usare l’intelligenza artificiale per influenzare la geopolitica e trarne vantaggio, eludendo i timidi esempi di regolamentazione di cui apprendiamo. Le minacce dell’intelligenza artificiale alle elezioni sono reali e crescenti, è fondamentale che i governi e i cittadini siano messi al corrente dei rischi e prendano misure per proteggersi.

È importante spiegare ai cittadini come identificarle queste campagne e invitarli a essere critici nei confronti dei contenuti che fruiscono attraverso i media e segnalare attività sospette ai gestori delle piattaforme. Ai governi, tuttavia, è affidato il compito più arduo, ovvero implementare misure tecnologiche in grado di individuare l’utilizzo dell’intelligenza artificiale per le finalità descritte. Sono necessarie cabine di regia che operino in un contesto internazionale e che coinvolgano e supportino anche le aziende i cui servizi possono essere utilizzati come vettori degli attacchi. I governi, inoltre, in maniera unanime dovrebbero considerare i processi elettorali come infrastrutture critiche da preservare con soluzioni tecnologiche ad hoc e adottando leggi per regolamentare l’uso dell’intelligenza artificiale generativa nelle elezioni.