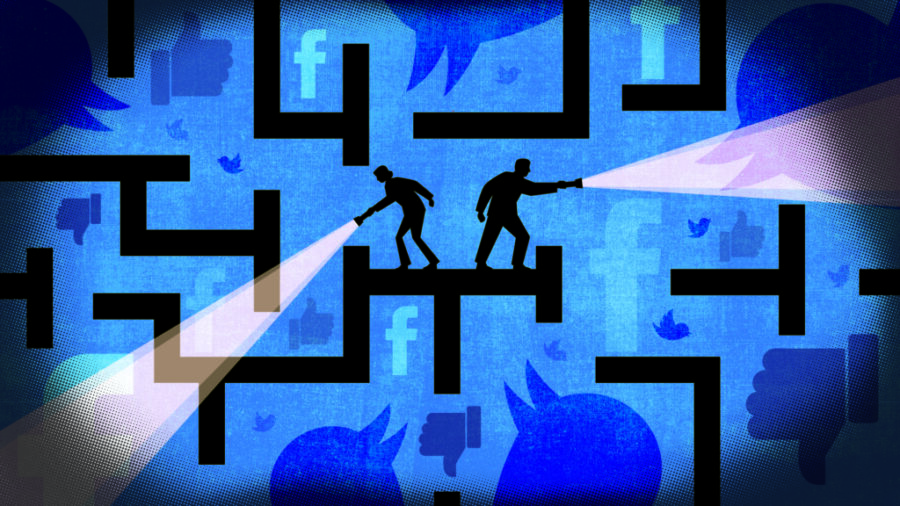

Le campagne di disinformazione alimentate dall’IA generativa rappresentano una minaccia per la trasparenza e la sicurezza delle elezioni, mettendo a rischio la stabilità delle democrazie

Quest’anno segna un momento cruciale per le democrazie globali, con elezioni in oltre cento Paesi che coinvolgeranno circa il 51% della popolazione mondiale. Ma la manipolazione delle notizie online, già determinante nelle scorse elezioni, ha subito un’evoluzione profonda. Con l’ascesa dell’IA generativa, sia la portata che la sofisticazione dei suoi mezzi sono cresciute a dismisura. La sfida si è evoluta.

Questi strumenti consentono approcci personalizzati sui social media e la creazione di contenuti falsi più convincenti, alimentando il dubbio su cosa è reale e cosa no in un contesto politico sempre più polarizzato. La natura “aperta” delle democrazie e dei media, in particolare negli Stati Uniti, unita all’impiego di tecnologie avanzate offre un terreno fertile per influenzare i processi elettorali.

Secondo l’ultimo rapporto trimestrale di Meta, pubblicato il 15 agosto, la Russia emerge come la “fonte principale” di comportamenti inautentici coordinati (Cib), con almeno 39 “operazioni di influenza occulta”, seguite da 30 dell’Iran e 11 della Cina. Al centro del rapporto c’è il cosiddetto “Coordinated inauthentic behaviour” (Cib), ovvero “sforzi coordinati volti a manipolare il dibattito pubblico per un obiettivo strategico in cui gli account falsi sono al centro dell’operazione”.

Il gigante tecnologico ha rilevato diverse tendenze nell’uso della nuova tecnologia per creare e amplificare la promozione di notizie false. In primo luogo, l’uso di siti web di notizie fittizie creati in Russia, che imitano articoli autentici provenienti da Internet, compresi quelli di media mainstream come Fox News e Telegraph, anche utilizzando alcune delle loro immagini e citandoli talvolta come fonti. Questi contenuti, generati e rielaborati da strumenti di IA, vengono intervallati con gossip e altri articoli di intrattenimento per attrarre e mantenere un pubblico vasto e per migliorare la visibilità online. Video su YouTube con lettori di notizie generati dall’IA e finti giornalisti con profili Internet realistici, spesso creati tramite reti gan (reti generative avversarie), completano il quadro.

In particolare, Meta ha osservato l’uso dell’IA generativa per creare contenuti e traduzioni nell’operazione “Doppelganger”, la più persistente campagna di influenza russa incentrata su una vasta rete di siti web che riproducono notizie legittime. Questa operazione sembra aver sfruttato la bassa qualità e la diffusione capillare dei suoi contenuti per creare un’impressione di onnipresenza su Internet, amplificando la percezione della sua influenza, molto più di quanto non abbia fatto nel tentativo di condurre una vera e propria campagna ingannevole.

L’attuale campagna disinformativa russa è per lo più incentrata sulla guerra in Ucraina. In vista delle elezioni americane di novembre, si prevede che le operazioni made in Russia promuoveranno contenuti a sostegno dei candidati presidenziali che si oppongono agli aiuti all’Ucraina, mentre i candidati pro-Kiev saranno bersaglio di attacchi. Ciò potrebbe tradursi nell’incolpare gli Stati Uniti per il sostegno finanziario all’Ucraina, nel presentare il governo ucraino come inaffidabile o nell’amplificare opinioni filorusse sulla guerra.

Per Meta, tuttavia, le tattiche basate sulla GenAI per diffondere la disinformazione russa sulle sue piattaforme hanno fornito “solo incrementi di produttività e generazione di contenuti” agli attori delle minacce, senza ostacolare “la capacità” del gigante social di “interrompere le loro operazioni di influenza”.

Una delle sfide più complesse per Meta riguarda il reclutamento di utenti, consapevoli o meno, da parte della Russia per creare contenuti. Quando tale coordinamento avviene al di fuori delle sue piattaforme, diventa difficile per l’azienda identificare e contrastare queste campagne. Per individuarle, Meta si concentra sul modo in cui agiscono gli account piuttosto che sui contenuti pubblicati.

Un esempio emblematico è l’account di “Sue Williamson”, che l’anno scorso ha diffuso un video di Vladimir Putin in cui affermava che la guerra in Ucraina riguardava i “principi su cui si baserà il Nuovo Ordine Mondiale”. In realtà, la donna non esisteva, era uno dei 968 bot creati dai russi su X. Questa vicenda ha riacceso le preoccupazioni a Capitol Hill, dove molti ricordano l’interferenza della Russia nel 2016, quando i suoi hacker rubarono e diffusero email della campagna di Hillary Clinton e presero di mira i database elettorali di diversi Stati.

Ma non c’è solo la Russia. Anche l’Iran ha intensificato la sua attività durante questo ciclo elettorale, con strategie sempre più aggressive che includono l’uso di siti web dall’aspetto professionale, hacker e attacchi di phishing. Microsoft ha recentemente segnalato un aumento significativo dell’attività di influenza da parte di gruppi iraniani, mentre Google ha dichiarato di aver individuato e interrotto un’operazione di phishing condotta da hacker iraniani per colpire sia la campagna di Trump che quella di Biden-Harris. Queste operazioni sono state una costante durante gli ultimi tre cicli elettorali negli Stati Uniti.

Gli esperti di intelligence avvertono che l’Iran sta adottando un approccio simile a quello della Russia durante le elezioni presidenziali del 2016, quando le famigerate “troll farm” inondarono i social media di contenuti falsi, favorendo ampiamente Trump rispetto alla candidata democratica Hillary Clinton. Oltre all’uso di piattaforme mediatiche, l’Iran sta intensificando gli attacchi di hacking e phishing nel tentativo di interferire con il voto presidenziale di novembre e seminare discordia in un clima politico già altamente polarizzato.

OpenAI ha recentemente annunciato di aver smantellato una sofisticata rete iraniana, denominata “Storm-2035”, che utilizzava il suo strumento ChatGPT per creare articoli di lunga durata e post più brevi sui social media incentrati su questioni altamente divisive, tra cui le elezioni presidenziali statunitensi, la guerra di Israele a Gaza e la presenza di Israele ai Giochi Olimpici. Il tutto, intervallando i contenuti politici con commenti sulla moda e sulla bellezza per apparire più autentici e nel tentativo di creare un seguito.

L’indagine ha beneficiato delle informazioni del Threat Analysis Center di Microsoft che aveva già segnalato le attività degli attori iraniani impegnati in operazioni di influenza rivolte al pubblico statunitense. Secondo il rapporto di Microsoft, la stessa rete era responsabile della creazione di quattro siti web che imitavano testate giornalistiche americane, con l’obiettivo di alimentare la sfiducia nel sistema democratico degli Stati Uniti e di accentuare le divisioni sociali. Tuttavia, l’ operazione non sembra aver ottenuto un coinvolgimento significativo del pubblico: la maggior parte dei post ha ricevuto un numero esiguo – o nullo – di like, condivisioni e commenti.

La campagna elettorale di Donald Trump ha già riferito di violazioni delle proprie comunicazioni interne, attribuendo gli attacchi a operazioni iraniane. Sebbene Storm-2035 non abbia ottenuto un ampio seguito, l’operazione rappresenta solo uno degli innumerevoli tentativi di usare l’IA in operazioni di influenza estera.

La crescente sofisticazione delle campagne di disinformazione, alimentata dall’uso dell’IA generativa, dimostra quanto le tecnologie emergenti stiano rivoluzionando, e complicando, il panorama della sicurezza elettorale globale. La domanda ora è: come reagire? La risposta forse risiede nella stessa tecnologia utilizzata per creare la disinformazione. Le piattaforme social dovrebbero sfruttare la potenza dell’IA per smascherare queste campagne.