Dalle elezioni americane a quelle europee, l’azienda di ChatGPT ha fermato più di 20 operazioni, dimostrando l’incapacità di questi tentativi di manipolazione di ottenere trazione significativa online. Nel rapporto anche un caso che riguarda l’Italia

OpenAI, la società di Sam Altman che ha creato ChatGPT, ha dichiarato di aver interrotto “più di 20 operazioni e reti ingannevoli da tutto il mondo che hanno tentato di utilizzare i nostri modelli” di intelligenza artificiale. In un rapporto di 54 pagine pubblicato ieri si legge che l’arsenale era composto da, tra gli altri, articoli di siti web generati dall’intelligenza artificiale e post sui social media da parte di account falsi. Nessuna delle operazioni è stata in grado di attirare un “coinvolgimento virale” o di creare un “pubblico sostenuto” attraverso l’uso di ChatGPT e degli altri strumenti di OpenAI, ha scritto la società.

Il 2024 è un anno particolarmente intenso sul fronte elettorale, con 4 miliardi di persone in più di 40 Paesi chiamate alle urne. Tra queste ci sono i cittadini americani, che tra meno di un mese dovranno scegliere il prossimo presidente, tra la vicepresidente Kamala Harris, democratica, e l’ex presidente Donald Trump, repubblicano. L’aumento dei contenuti generati dall’intelligenza artificiale ha alimentato le attività di disinformazione e influenza nelle elezioni. Basti pensare che il numero di deepfake creati è aumentato del 900% di anno in anno, secondo i dati della società Clarity.

OpenAI ha definito il suo aggiornamento sulle “operazioni di influenza e cibernetiche” come una “istantanea” di ciò che sta vedendo per identificare “una prima serie di tendenze che riteniamo possano informare il dibattito su come l’intelligenza artificiale si inserisce nel più ampio panorama delle minacce”.

Nel rapporto si legge che gli utilizzi dell’intelligenza artificiale legati alle elezioni “variano in termini di complessità da semplici richieste di generazione di contenuti a complessi sforzi in più fasi per analizzare e rispondere ai post sui social media”. Secondo OpenAI, i contenuti dei social media riguardavano soprattutto le elezioni negli Stati Uniti e in Ruanda e, in misura minore, le elezioni in India e nell’Unione europea.

Qualche esempio: a fine agosto, un’operazione iraniana ha utilizzato i prodotti di OpenAI per generare articoli e commenti sui social media ma la maggior parte dei post identificati ha ricevuto pochi o nessun like, condivisione e commento; a luglio, OpenAI ha vietato gli account ChatGPT in Ruanda che pubblicavano commenti sulle elezioni su X; a maggio, un’azienda israeliana ha usato ChatGPT per generare commenti sui social media sulle elezioni in India, un caso risolto da OpenAI in meno di 24 ore; A giugno, OpenAI ha affrontato un’operazione che ha utilizzato i suoi prodotti per generare commenti sulle elezioni del Parlamento europeo in Francia e sulla politica negli Stati Uniti, in Germania, in Italia e in Polonia.

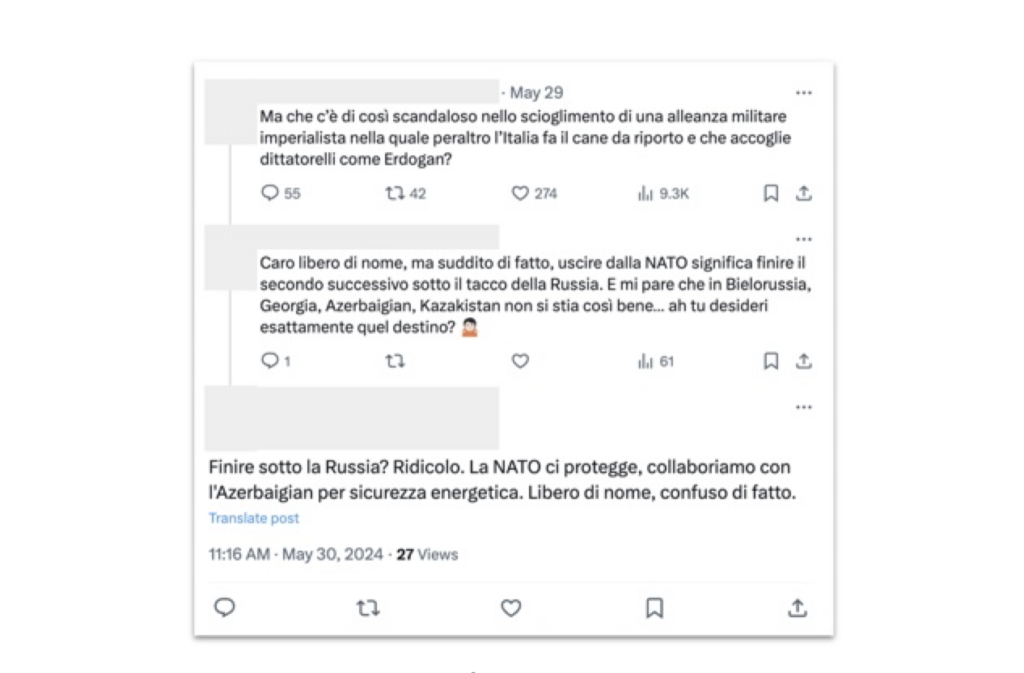

Con riferimento a quest’ultimo caso, l’azienda ha dichiarato che, mentre la maggior parte dei post sui social media identificati ha ricevuto pochi like o condivisioni, alcune persone reali hanno risposto ai post generati dall’intelligenza artificiale. È capitato in italiano, con account che elogiavano il ruolo dell’Azerbaijan come fornitore energetico dell’Europa, a volte in risposta a critiche al governo azero per la situazione sui diritti umani.

Con riferimento a quest’ultimo caso, l’azienda ha dichiarato che, mentre la maggior parte dei post sui social media identificati ha ricevuto pochi like o condivisioni, alcune persone reali hanno risposto ai post generati dall’intelligenza artificiale. È capitato in italiano, con account che elogiavano il ruolo dell’Azerbaijan come fornitore energetico dell’Europa, a volte in risposta a critiche al governo azero per la situazione sui diritti umani.