Lettera da New York di Oreste Pollicino, ordinario di diritto costituzionale all’università Bocconi che in questo anno accademico è Fulbright Scholar e Global Fellow alla New York University. Che ha assistito alle audizioni di vertici di grandi corporation tecnologiche, accademici e policy-maker alla ricerca di un modello di regolazione normativa di carattere non settoriale per l’Intelligenza artificiale. Ecco cosa è emerso

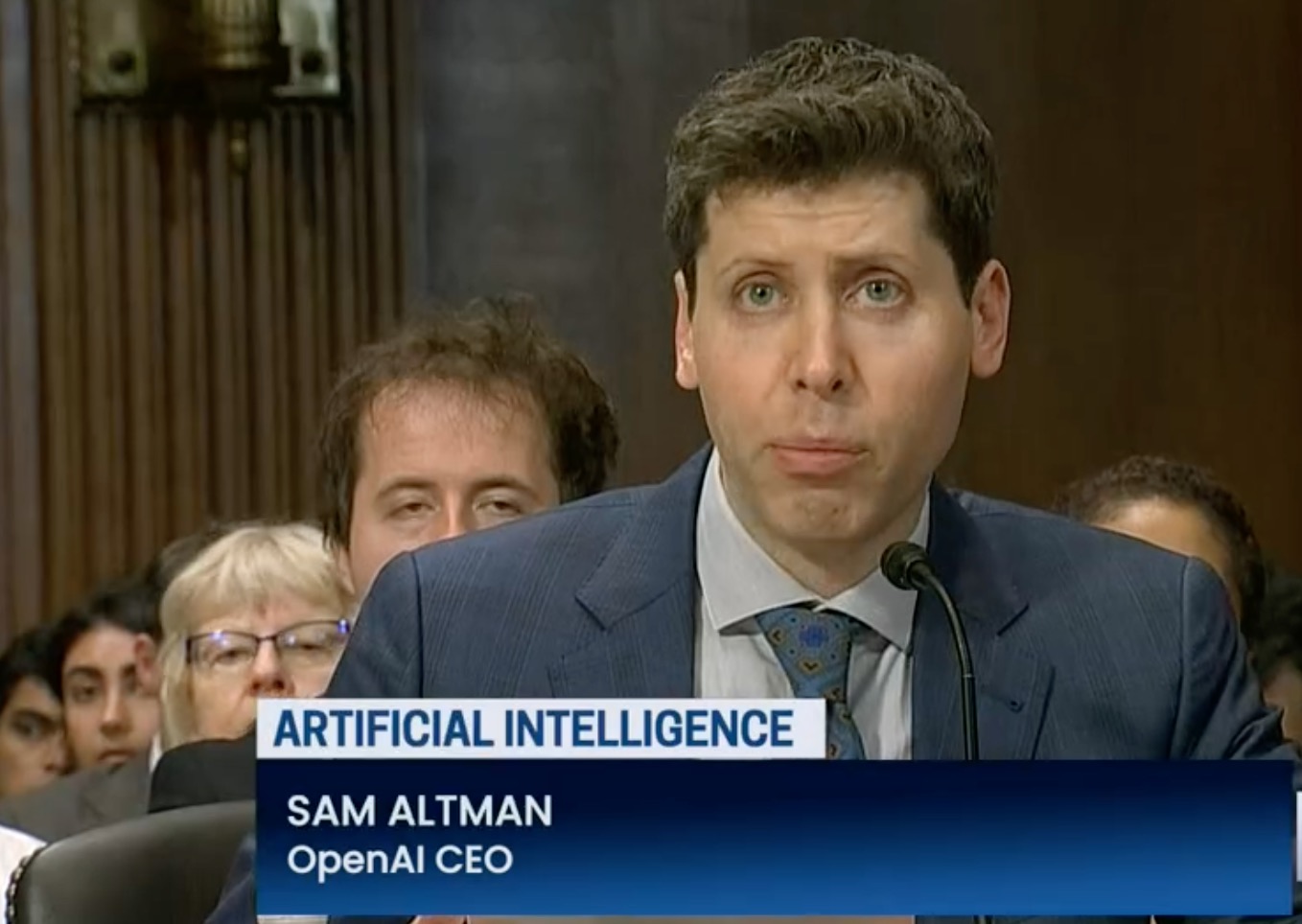

Se soltanto l’anno scorso, o anche qualche mese fa, mi avessero detto che di fronte al sub-Committee for privacy, Technology and law del Senato americano ci sarebbe stata una serie di audizioni da parte di vertici di grandi corporations tecnologiche, accademici e policy-makers relative alle modalità di implementare un modello di regolazione normativa di carattere non settoriale per l’Intelligenza artificiale negli Stati Uniti, avrei pensato ad uno scenario tanto futuristico quanto irrealistico.

Invece oggi è pura realtà. La scorsa settimana ho assistito alla seconda di queste audizioni, assai interessante anche perché nel frattempo, altra cosa qualche tempo fa assolutamente impensabile, al Senato americano è stata depositata una proposta di legge bipartisan che ambisce ad istituire una agenzia federale indipendente di controllo per l’intelligenza artificiale e tutta un’altra serie di vincoli per produttori e distributori della tecnologia (meglio: ecosistema digitale) in questione, sia per quanto riguarda la parte del design della stessa tecnologia (input), sia per quanto riguarda la gestione del prodotto finale (output).

Inoltre, e si tratta di un passaggio di capitale importanza, l’idea alla base (da vedere quanto condivisa) è di chiarire che l’immunità a favore degli Internet service providers – la famigerata Section 230 del Communications Decency Act of 1996 che ha consentito l’esplosione commerciale del web – non si applicherebbe all’intelligenza artificiale. Il che ovviamente avrebbe come immediata conseguenza che le grandi corporations di IA potrebbero essere considerate responsabili per i danni causati dai modelli di IA. Si pensa anche di introdurre un obbligo per le stesse società di informare gli utenti che stanno interagendo con detti modelli e che non vi è nulla di “umano”, in senso tecnico, quale interlocutore.

Perché questa accelerazione?

Ci sono almeno tre ragioni a mio avviso.

In primo luogo, si vuole evitare che l’inerzia porti a subire il Brussels effect (dopo il Gdpr) anche con la regolamentazione dell’intelligenza artificiale. Il che vuol dire non agire solo di rimessa, come è capitato per alcuni Stati federati (per esempio la California) una volta che la normativa rilevante sia entrata in vigore, ma promuovere un modello, per forza di cosa alternativo a quello europeo, essendo assai diverso l’humus costituzionale di riferimento, prima che i giochi siano chiusi con riguardo all’AI Act (e i giochi potrebbero chiudersi molto presto perché la presidenza spagnola vorrebbe arrivare ad un testo definitivo entro dicembre in modo da poter attribuirsi il merito di aver trovato il compromesso tra Parlamento e Consiglio dei ministri dell’Unione).

In secondo luogo, il legislatore federale vuole evitare (cosi come è successo per la normativa di protezione dati) di essere tagliato fuori dalle iniziative legislative degli Stati, ad iniziare, anche in questo caso, dalla California, che ospitando tecnologia e sede della maggior parte delle corporations, vuole dettare le regole del gioco (come ha già fatto a proposito della protezione dati, con una sorta di cherry picking delle norme del Gdpr).

In terzo luogo, il 2024 sarà l’anno delle elezioni presidenziali. L’accoppiata intelligenza artificiale e disinformazione, a cominciare dai temutissimi deepfakes, rischia di essere un cocktail esplosivo (e manipolativo del dibattito pubblico che ormai si svolge per la gran parte in rete). Qui ovviamente l’obiettivo è salvaguardare la sicurezza nazionale da attacchi esterni (Cina e Russia sono visti come gli indiziati principali), anche per quanto riguarda le differenti, ma altrettanto efficaci, tecniche di disinformazione.

Il problema è che negli Stati Uniti vi è una situazione abbastanza paradossale quanto al (non) contrasto contro la disinformazione on line.

Da una parte, come si diceva, si avverte un certo terrore – direi fondato, visto quanto è stato provato nelle elezioni politiche Trump vs Clinton, quanto ai professionisti della disinformazione che hanno inquinato il dibattito e provato ad incidere sull’esito delle votazioni – delle possibili interferenze esterne per le elezioni del 2024 e vi è già una proposta di legge in cantiere al Congresso.

Dall’altra, vi è un altro terrore che aleggia e costituisce quasi un tabù per ogni tentativo di regolazione. Quello, anche in questo caso culturalmente prima che costituzionalmente comprensibile, di poter minare in qualsiasi modo le fondamenta di sua maestà free speech. E dunque anche una semplice comunicazione da parte della Casa Bianca in cui si chiede alle grandi piattaforme di impegnarsi ad evitare che in rete vi siano contenuti falsi rispetto a temi sensibili come quello elettorale e della salute pubblica viene considerata, qualche giorno fa, dalla Fifth Circuit Court of Appeals in contrasto con il Primo Emendamento.

Si tratta di una bipolarità che va ridotta, se non a unità, a un minimo di armonia prima di pensare a qualsiasi strategia contro la disinformazione che vada oltre la self-regulation. Certamente irrealistico in questo momento pensare ad innestare in questo tessuto, prima ancora che giuridicamente, culturalmente assai frammentario ed acerbo, il meccanismo di co-regolamentazione alla base del nuovo Codice Ue contro la disinformazione della cui scrittura sono stato il coordinatore. Il rischio è quello di una crisi di rigetto.

Chiudo con una nota evidenza un paradosso transatlantico riguardo alla regolamentazione dell’intelligenza artificiale.

La maggior parte degli esperti indipendenti che sono stati ascoltati nelle audizioni prima menzionate, lamentano che le legislazioni rilevanti (peraltro assai settoriali e frammentarie) si fondano esclusivamente su regole procedurali e non su valori sostanziali. In Europa ci abbiamo messo 20 anni per capire (con il Dsa e in parte con AI Act) che costruire una regolamentazione europea dell’ecosistema digitale soltanto su valori costituzionali sostanziali dell’Ue (vedi Gdpr) rischia di realizzare una fortezza europea inespugnabile all’interno ma senza ponti levatoi di interconnessione con gli altri poli geopolitici rilevanti (Usa se guardiamo a cosa sta sotto l’ombrello della rule of law, per la Cina un discorso diverso). In altre parole, il due data process che ha iniettato la recente normativa europea quanto a regolamentazione del digitale rischia di perfezionarsi proprio quando dall’altra parte dell’oceano puntano su un costituzionalismo digitale di natura sostanziale e non procedurale.