La nuova lettera da New York del prof. Oreste Pollicino. Il presidente Biden ha adottato l’AI executive order, che costituisce la prima iniziativa, quanto a opzioni di regolamentazioni dell’intelligenza artificiale, nella storia statunitense di ordine quanto meno parzialmente vincolante, e non (totalmente) basato sulle buone intenzioni e impegni volontari delle grandi piattaforme. Ecco in cosa consiste e quali differenze ci sono con la regolamentazione europea

Ieri è stato una sorta AI Monday per gli Stati Uniti. Non si può ancora però parlare, per quanto si dirà di un Washington effect contrapposto al Bruxelles effect.

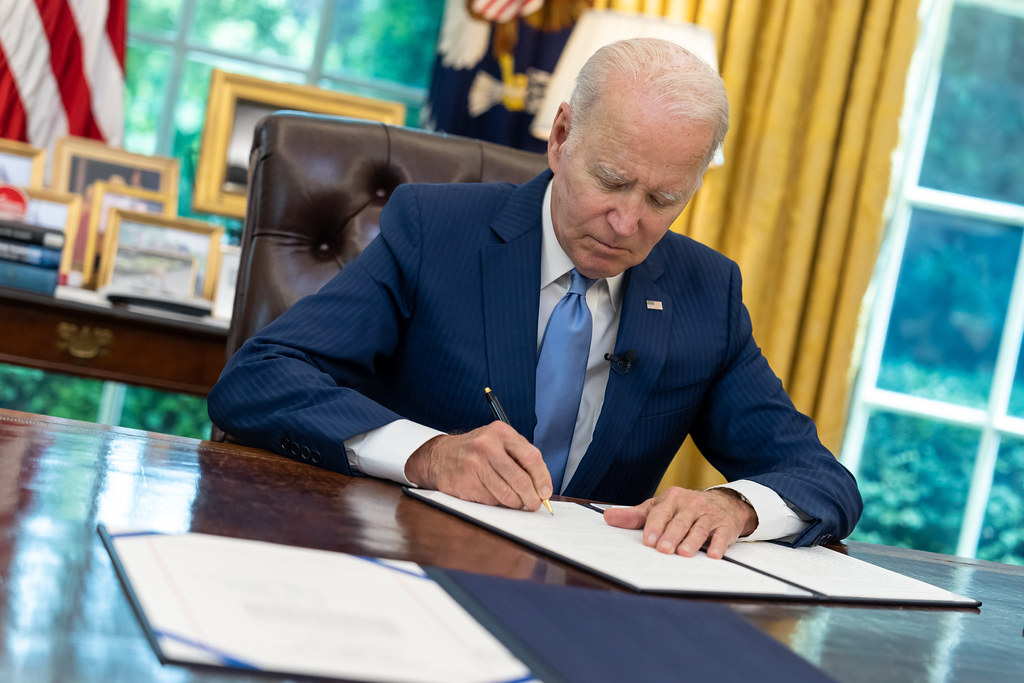

Il presidente Joe Biden ha adottato un provvedimento peraltro annunciato da qualche tempo, l’AI executive order, che costituisce la prima iniziativa, quanto a opzioni di regolamentazioni dell’intelligenza artificiale, nella storia statunitense di ordine quanto meno parzialmente vincolante, e non (totalmente) basato sulle buone intenzioni e impegni volontari delle grandi piattaforme. Sicuramente dunque un cambio di marcia.

La Casa Bianca nel commentare detto cambio si è forse fatta prendere un po’ troppo dall’entusiasmo dichiarando come l’executive order in questione rappresenterebbe “the strongest set of actions any government in the world has ever taken on AI safety, security, and trust”.

Non ci sono dubbi che l’AI Act europeo sia assai più vincolante e incisivo, forse eccessivamente, come si è scritto su queste pagine, in merito al rischio di una pietrificazione della tecnologia.

In questa sede, in ogni caso, l’esercizio di identificare la legislazione più rigorosa sul tema sarebbe nel migliore dei casi poco utile e nel peggiore fuorviante, in quanto, per l’appunto, non si sta commentando, lato Usa, una legge ma un decreto presidenziale. Quest’ultimo contiene sia obblighi (pochi) che linee guida (moltissime) e va sicuramente oltre il modello preesistente di self-regulation. Executive order che è stato adottato proprio perché la proposta bipartisian del Congresso di cui si è parlato nelle lettere precedenti, assai ambiziosa nel prevedere un organismo indipendente di supervisione ed una forma di responsabilità per i produttori di AI, rischia di essere lettera morta per l’eccessivo grado di polarizzazione dell’organo legislativo statunitense.

Proprio per questo l’amministrazione Biden ha scelto la corsia preferenziale dell’executive order, che non necessità di alcuna approvazione parlamentare ed è immediatamente efficace. Non solo, ma non può essere modificato dal Congresso, anche se indirettamente può essere svuotato di efficacia, per esempio con una decisione parlamentare di non autorizzare lo stanziamento di budget necessario per implementare l’executive order. D’altro canto l’executive order può essere modificato a piacimento dal prossimo presidente (e alcuni incubi si potrebbero materializzare a novembre del 2024) e specialmente manca, ovviamente, della legittimazione che caratterizza l’adozione di una normativa parlamentare.

Tornando ai contenuti di quest’ultimo, va subito precisato, che in linea con quanto si è già avuto modo di sostenere in passato identificando le bussole guida per gli esercizi regolatori in tema di intelligenza artificiale sulle due sponde dell’Atlantico, che mentre stella cometa dell’AI Act è, almeno in via teorica, la protezione dei diritti fondamentali, il nuovo l’executive order ruota tutto intorno alle due parole chiave: safety and security. In altre parole è un approccio più legato alla cybersicurezza e all’evitare interferenze esterne ai danni della national security americana.

Le radici fortemente concentrate sulla dimensione nazionale del problema e non invece sull’afflato più universale legato alla protezione dei diritti fondamentali (per cui ovviamente Bruxelles effect funziona meglio che Washington effect in questo contesto) lo si vede anche, leggendo le 111 pagine della bozza disponibile, guardando la quasi ossessiva puntualizzazione dei destinatari: Americans first.

Chi si aspettasse degli obblighi diretti e puntuali nei confronti delle grandi piattaforme che producono e distribuiscono applicazioni di intelligenza artificiale potrebbe restare deluso. L’idea è ancora, e non poteva essere diversamente visto l’humus culturale prima che giuridico statunitense, quella di incentivare gli operatori privati a lavorare su best practices: qualsiasi intrusione governativa sul modello di business di tali operatori sarebbe considerata irragionevole e probabilmente incostituzionale.

L’executive order invece identifica come interlocutrici privilegiate le agenzie federali competenti in tema, innanzitutto di safety, security e consumer protection (purtroppo non si fa riferimento invece alla Electoral Commission che potrebbe giocare un ruolo fondamentale, come si è detto nelle lettere precedenti, nella lotta alla disinformazione).

Èproprio in questo tentativo di empowerment delle agenzie, che diventano di fatto guardiane della implementazione (anche se assai poco viene detto su quali dovrebbero essere le modalità alla base di tale processo) dei principi contenuti nell’executive order che si rintraccia forse il valore aggiunto di quest’ultimo. Un esempio su tutti che può dare l’idea della discontinuità, sotto questo aspetto, rispetto al passato si legge nel punto 4.1 che va la pena di riportare:

4.1. Developing Guidelines, Standards, and Best Practices for AI Safety and Security. (a) Within 270 days of the date of this order, to help ensure the development of safe, secure, and trustworthy AI systems, the Secretary of Commerce (…) shall:

(i) develop guidelines and best practices, with the aim of promoting consensus industry standards, for developing and deploying safe, secure, and trustworthy AI systems (…)

(ii) establish appropriate guidelines (except for AI used as a component of a national security system), including appropriate procedures and processes, to enable developers of AI, especially of dual-use foundation models, to conduct AI red-teaming tests to enable deployment of safe, secure, and trustworthy systems

Qui vi è una scadenza perentoria entro la quale l’organo competente si attivi quale, per l’appunto, enforcer, come si diceva, dei principi guida dell’Executive Order e faccia di fatto, quello che l’amministrazione direttamente non può fare, partendo sempre dalle best practices e da guidelines non vincolanti.

Alla domanda che molti si stanno facendo, se si tratti un ordine che morde o che soltanto abbaia, la risposta non può essere univoca.

Diciamo che si è fatto tutto quello che al momento è possibile fare in un contesto strutturalmente improntato alla sef-regulation. Un modello che non può essere smentito ma affiancato, in modo chirurgico e proporzionale, ma anche incrementale, da un modello di coregolamentazione.

E tutto questo per due ragioni fondamentali. Da una parte per tutelare la sicurezza nazionale ed evitare interferenze esterne, specie nella prossima stagione elettorale. Dall’altra parte per non subire passivamente, come si è fatto per il Gdpr, il temuto, perché a volte omologante, a dispetto dei valori costituzionali in gioco non sempre coincidenti, Bruxelles effect.