Il governo degli Stati Uniti è intervenuto per chiedere alle agenzie federali di “identificare e gestire i potenziali pericoli” derivanti dalla tecnologia. Non è la prima volta che si procede in questo modo. Ma per regolarla in modo più strutturato serve l’appoggio del Congresso, che ad oggi manca

Tra i tanti rischi derivanti dall’intelligenza artificiale c’è la discriminazione. Quello che viene denunciato da alcune organizzazioni è che l’IA viene sviluppata per lo più da uomini e donne bianche in condizioni agiate, che potrebbero avere meno sensibilità. È una delle preoccupazioni fatte presenti alla vice presidente degli Stati Uniti, Kamala Harris, che ha annunciato in conferenza stampa una serie di nuove misure volute dal governo per le pubbliche istituzioni al fine di “identificare e gestire i potenziali pericoli”, offrendo al tempo stesso “trasparenza” nell’utilizzo della tecnologia. È l’ultima mossa della Casa Bianca per regolare l’IA, per “proteggere” la sicurezza dei propri cittadini affinché “sappiano come il loro governo la sta integrando”.

La direttiva è stata emanata alle varie agenzie federali dall’Office of Management and Budget, per controllare, analizzare e testare l’impatto dell’IA, conducendo un’attenta valutazione dei rischi e stabilendo dei paletti entro cui operare. Come precisato da Harris, le amministrazioni saranno anche chiamate a una “supervisione interna, con la designazione di un responsabile dell’IA” che abbia “l’esperienza, la competenza e l’autorità necessarie” per assicurare un corretto utilizzo degli strumenti tecnologici. Il governo ha dato sessanta giorni di tempo per designare queste figure, mentre a completare le squadre saranno cento nuovi funzionari assunti.

L’analisi interesserà ovviamente tutti i settori critici, a cominciare dalla sicurezza nazionale, passando per l’economia e la sanità. I Centers for Disease Control and Prevention sfrutta ad esempio l’IA per la prevenzione delle malattie e per prevenire l’uso di oppioidi, una vera e propria piaga negli States. Naturalmente, anche i disastri ambientali meritano attenzione. La Federal Emergency Management Agency la utilizza invece per prevenire gli eventi estremi, sempre più frequenti a causa degli effetti del cambiamento climatico. Ma la valutazione riguarderà anche il mercato del lavoro, quello che più potrebbe subire le conseguenze della digitalizzazione, con molti che temono di vedersi sostituiti dalle macchine.

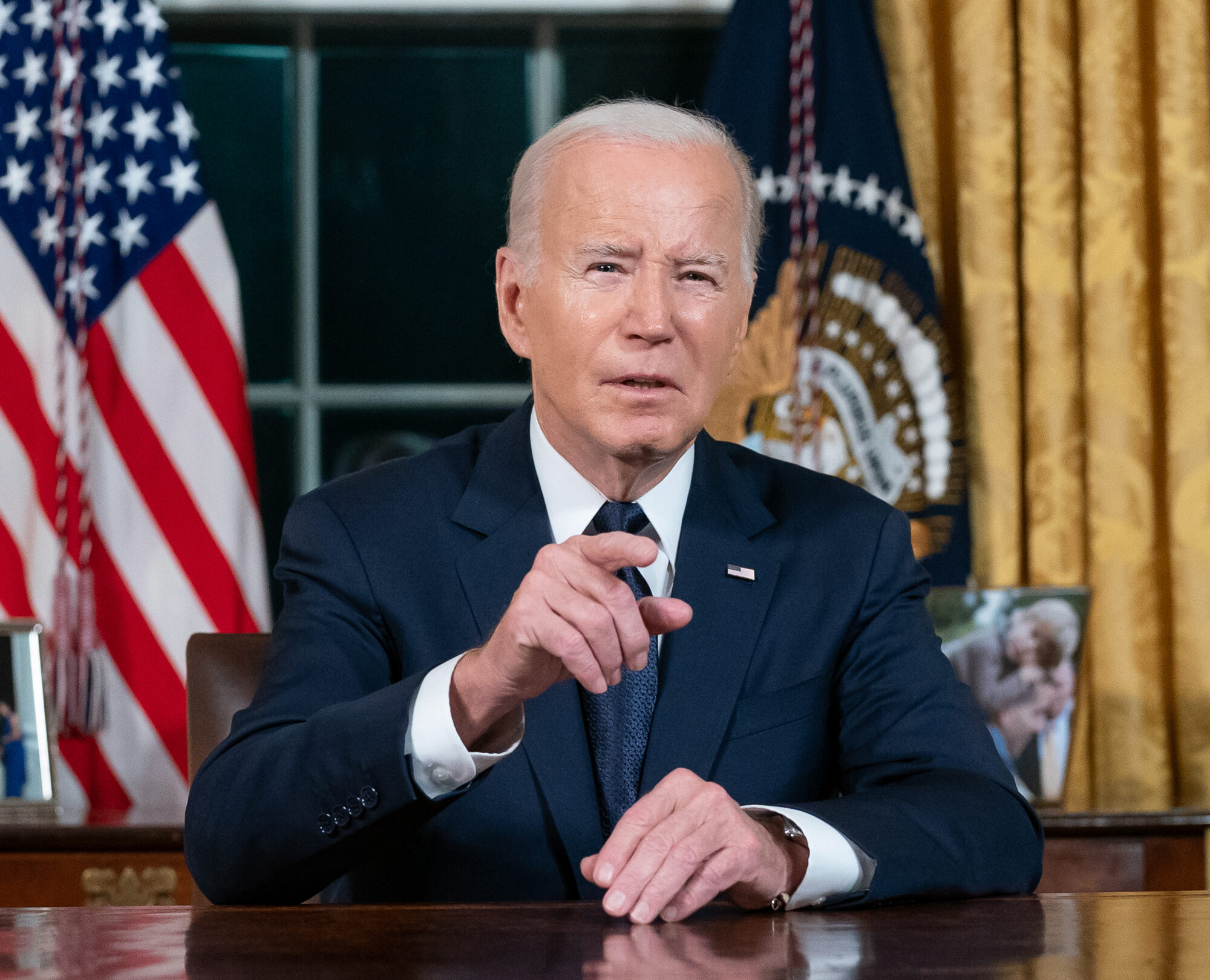

La nuova decisione si inserisce all’interno di una serie di mosse promosse dall’amministrazione di Joe Biden, che seguono input internazionali. Quelli diretti, come la prima risoluzione con cui l’Assemblea dell’Onu ha chiesto che la tecnologia venga utilizzata per il progresso, portando al minimo le controindicazioni, e i regolamenti interni di cui si è dotata l’Unione europea, di cui il più importante è l’AI Act. E quelli indiretti, come la concorrenza della Cina che cerca di ridurre il gap dagli americani.

Nell’ottobre scorso, la Casa Bianca aveva già emanato un executive order – in capo al presidente – diretto agli sviluppatori e alle agenzie federali. Ai primi veniva richiesto di ridurre al minimo i rischi provenienti dai loro strumenti, da testare insieme alle istituzioni governative; alle seconde di stabilire un quadro entro cui effettuare questi esami preliminari e di affrontare le minacce.

L’avvertimento lanciato da Biden cinque mesi fa era che, finendo nelle mani sbagliate, l’IA è capace di tutto. Anche di ritorcersi contro, motivo per cui il presidente americano è intervenuto più volte. Ma il suo è un segnale, una spinta per arrivare a una legislazione più ampia. Per cui però serve l’appoggio del Congresso, quello che ad oggi manca (i democratici hanno la maggioranza solo al Senato) e che rende monchi i suoi ordini esecutivi.