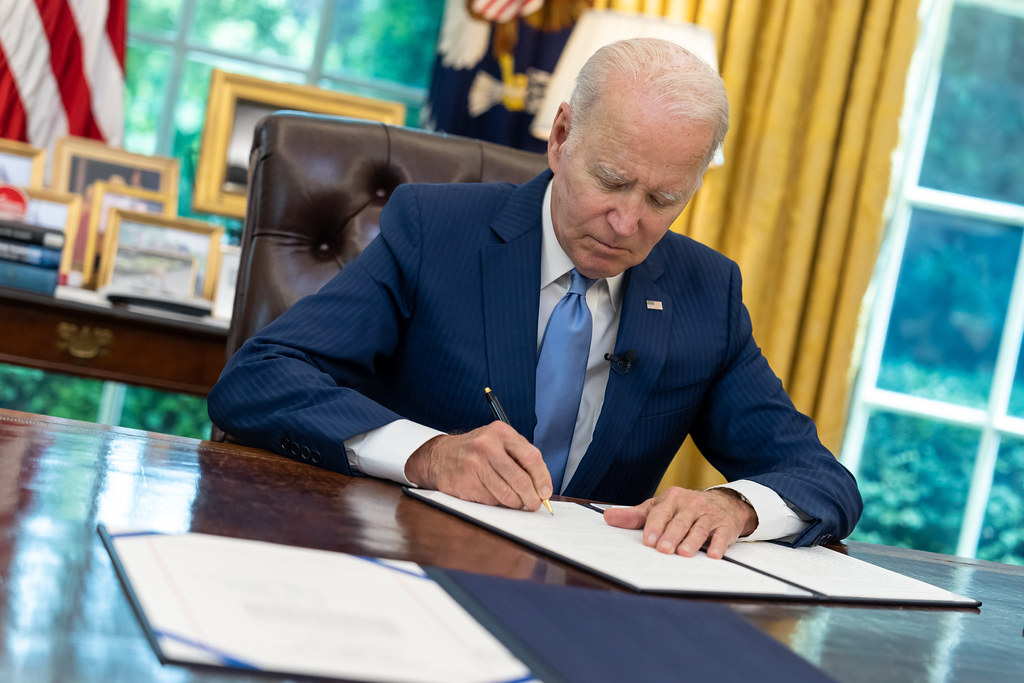

Gli effetti dell’ordine presidenziale di Joe Biden, firmato lo scorso ottobre, sono stati discussi durante un webinar del Center for security and emerging technology (Cset) della Georgetown University, intitolato “AI Executive Order Report Card”. La lezione americana può servire agli europei per la loro regolamentazione, che dovrebbe compiere un ulteriore passo in avanti per ridurre i rischi. I due approcci sono differenti, ma possono convivere

Un’analisi costi benefici per valutare l’impatto dell’ordine esecutivo firmato dal presidente Joe Biden sull’intelligenza artificiale allo scadere di ottobre. Con l’emergere di nuovi strumenti si moltiplicano i rischi e l’obiettivo del documento presidenziale era indirizzare e sensibilizzare le agenzie governative a un uso “sicuro, protetto e affidabile” dell’IA. Tre mesi dopo, è tempo di vedere gli effetti che ha provocato, ancor di più con l’Unione europea che è chiamata a decidere in merito al suo AI Act, che si preoccupa di compiere un passo in avanti rispetto agli Stati Uniti.

Il webinar organizzato dal Center for security and emerging technology (Cset) della Georgetown University, intitolato “AI Executive Order Report Card” si era prefissato proprio questo obiettivo, discutendo insieme ad alcuni analisti dell’executive order, all’interno di un filone di seminari sulle nuove tecnologie emergenti.

“L’ordine esecutivo ha stabilito molto chiaramente una tempistica per la valutazione del rischio dell’IA nelle infrastrutture critiche”, è stato il pensiero di Jack Corrigan, analista di ricerca al Cset. “Ha incaricato le agenzie responsabili della regolamentazione dei diversi settori delle infrastrutture critiche di utilizzare il NIST Risk Management Framework e di inserirlo nelle linee guida esistenti in materia di sicurezza”. Proprio negli ultimi giorni, alti funzionari dell’Fbi hanno messo in guardia su quanto sia alto il pericolo che gli hacker cinesi possano intromettersi nelle infrastrutture critiche statunitensi (impianti idrici ed elettrici, oleodotti, gasdotti e snodi di trasporto) in modo tale che, quando e se Pechino avrà intenzione di lanciare un attacco, lo farà partendo da lì.

Bisogna tuttavia tener conto anche degli aspetti meno piacevoli. A metterli in risalto è stata Heather Fraase, ricercatrice del Cset esperta di IA. “Molte delle direttive suggeriscono alle persone di pianificare o sviluppare linee guida. È un passo importante, ma non significa che queste misure di sicurezza per garantire i sistemi di IA responsabili saranno effettivamente implementati. Si tratta di un ulteriore passo in avanti”, questo è innegabile, ma “ci servono finanziamenti” per concretizzare le buone intenzioni. “È uno dei limiti di un ordine esecutivo. Ciò non vuol dire che sia carente, ma solo che può fare questo. Ha fatto ciò che può fare, ma non risolverà da solo i nostri problemi”. Altre lacune sembrano esserci nella definizione delle competenze e dei ruoli tecnici e non di chi dovrà occuparsi dell’IA, come suggerito da Luke Koslosky, anche lui ricercatore del Cset con una specializzazione in politiche lavorative.

Tra i diktat della Casa Bianca c’erano quello di chiedere alle aziende che sviluppano sistemi di IA molto potenti di condividere informazioni relative alla sicurezza e lo sviluppo di strumenti e test per renderli affidabili e ridurre i rischi. Abbatterli è il fine ultimo, così da poter sfruttare solo (o quasi) i benefici che l’intelligenza artificiale può trasmettere.

Un approccio simile e allo stesso tempo differente rispetto a quello europeo. Il governo statunitense, hanno sottolineato i ricercatori durante il webinar, non ha alcuna intenzione di sostituirsi al privato o, ancor peggio, di soffocare l’iniziativa di quest’ultimo. In termini di finanziamenti, non c’è infatti paragone. Washington dunque non vuole pareggiare il conto, quanto piuttosto guidare le aziende verso un percorso sicuro, dando dimostrazione di seguire attentamente la transizione tecnologica.

In Europa invece si è passati direttamente a un testo normativo. O meglio, ci si prova. Dopo trentasei ore di negoziati, a fine anno scorso si è arrivati a una storica intesa sull’AI Act che renderebbe l’Ue la prima a darsi a una regolamentazione in merito. Oggi pomeriggio verrà votato dal Coreper, che poi dovrà seguire un iter lungo un anno prima di diventare definitivamente realtà. Il testo può subire modifiche, ma quello che è uscito fuori dopo il trilogo dovrebbe basarsi su diverse categorie di rischio, secondo cui più è alto più sono rigide le regole, così come sui campi in cui l’IA può operare e, soprattutto, in cui non può.

Stati Uniti ed Europa dunque vogliono raggiungere lo stesso obiettivo – un’IA sicura ed affidabile – ma seguendo percorsi differenti. Non del tutto opposti, ma sicuramente diversi. Dall’alto quello europeo, dal basso quello americano; più severo il primo, più permissivo il secondo (come vuole la cultura di entrambi). Una commistione tra i loro approcci sarebbe perfetta e forse è su questo che i due alleati devono lavorare.